以太坊 V 神也投資!新公鏈 MegaETH 是什麼?為何能融資 2 千萬鎂?

MegaETH 以首個即時區塊鏈為賣點,獲 Dragonfly 領投,並有多位頂級投資人參與。該項目強調高性能和即時處理,並提出節點專業化方案。

基建永不眠,鏈比應用多。

當市場被各種天王項目空投的 PUA 折磨的叫苦不迭時,一級市場還在「造天王」的路上狂奔。

昨天夜裡,另一個陣容炸裂的 Layer1 橫空出世---MegaETH,種子輪融資 2,000 萬美元,Dragonfly 領投,Figment Capital、Robot Ventures 和 Big Brain Holdings 等機構參投,天使投資人包括 Vitalik、Cobie、Joseph Lubin、Sreeram Kannan、Kartik Talwar 等。

頂級 VC 領投、Vitalik 等圈內大神們充當天使投資人、項目名字直接帶上了「ETH」...注意力有限的加密市場裡,這些標籤無不在給項目找「正統性」。

從官方項目描述來看,MegaETH 還是能用一個熟悉的字就能概括---快。

首個即時區塊鏈(Real-Time Blockchain)、以閃電般的速度傳輸交易、亞毫秒級延遲和每秒超過 100,000 筆交易...

在市場所有參與者都對公鏈性能敘事審美疲勞的現在,MegaETH 靠什麽突出重圍?

我們扒了扒 MegaETH 的白皮書,試圖找到答案。

鏈很多,但都無法做到「即時化」

假設除開敘事和炒作,為什麽市場上還需要一個叫 MegaETH 的區塊鏈?

MegaETH 自己給出的答案是,簡單地創建更多鏈並不能解決區塊鏈可擴充功能性問題,現在的 Layer1、Layer2 們面臨著共性問題:

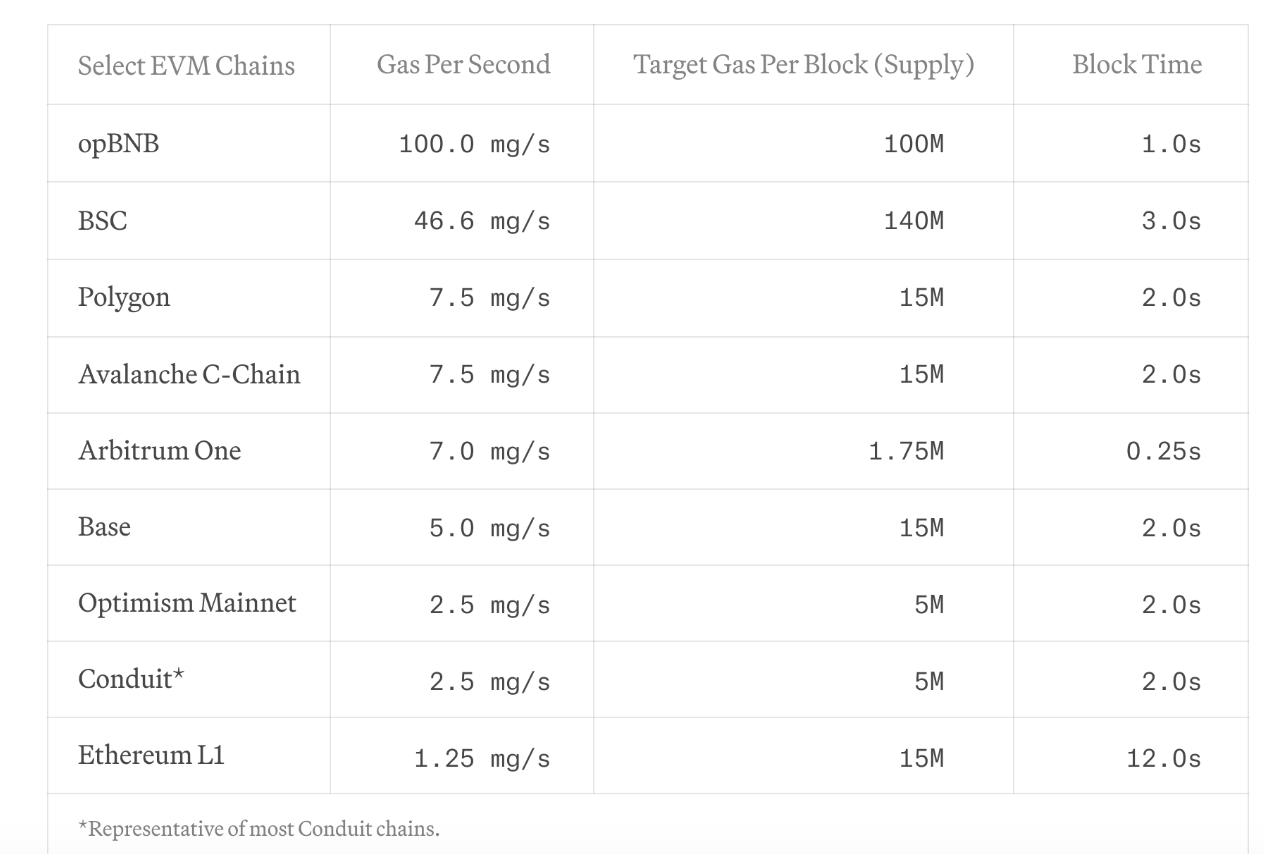

- 所有 EVM 鏈都表現出較低的交易吞吐量;

- 其次,由於計算能力稀缺,複雜的應用程式無法上鏈;

- 最後,需要高更新率或快速回饋循環的應用程式在較長的出塊時間內是不可行的。

也就是說,現行所有的區塊鏈其實無法做到:

- 即時結算:交易在到達區塊鏈時立即被處理並且結果幾乎即時發布。

- 即時處理:區塊鏈系統能夠在極短的時間內處理和驗證大量的交易。

這種即時化,落到實際應用場景裏是什麽東西?

比如高頻交易,需要能夠在毫秒內完成訂單的下單和取消操作。又或者是即時戰鬥或物理仿真的遊戲,需要區塊鏈能夠以極高的頻率更新狀態。很顯然現在的鏈都做不到。

節點專業化,性能即時化

那麽,要做到上述的「即時化」,MegaETH 的大概思路是啥?

太長不看版就是:節點專業化:通過分離交易執行任務和完整節點的職責,減少共識開銷。

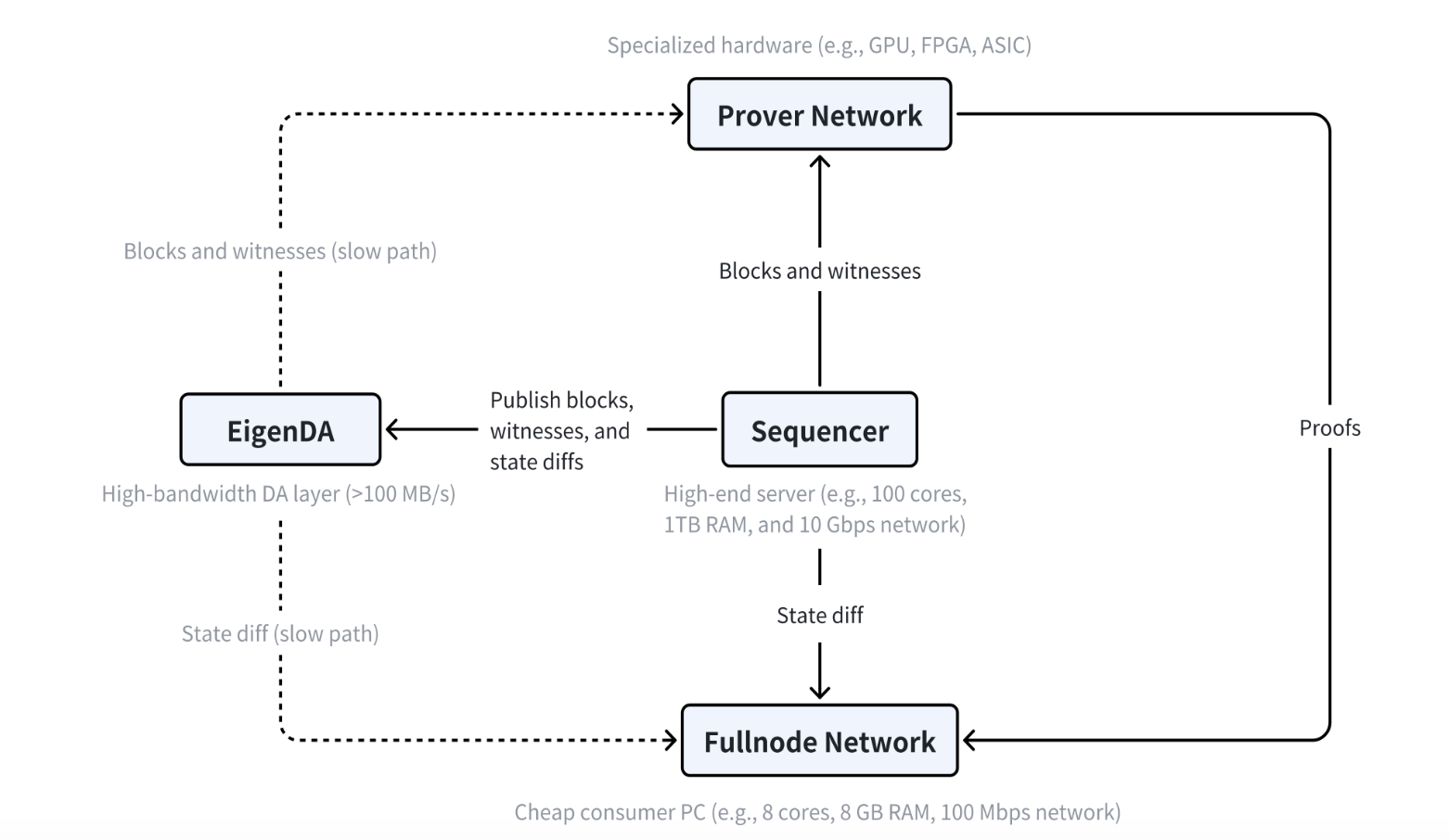

如果要具體一點,可以看到 MegaETH 中有三個主要角色:排序器、證明者和全節點。

具體來說,MegaETH 中只有一個活躍的排序節點(sequencer)在任意時間執行交易,其它節點通過 P2P 網路接收狀態差異並更新本地狀態,而無需重新執行交易。

排序器負責對使用者交易進行排序和執行。但是,MegaETH 在任何給定時間都隻有一個活躍的排序器,從而消除了正常執行期間的共識開銷。

證明者使用無狀態驗證方案,以異步和無序的方式驗證區塊。

一個 MegaETH 簡易的工作流程如下:

- 交易處理和排序:使用者提交的交易首先被發送到 Sequencer(排序器),排序器按順序處理這些交易,生成新的區塊和見證數據。

- 數據發布:排序器將生成的區塊、見證數據和狀態差異發布到 EigenDA(數據可用性層),確保這些數據在網路中可用。

- 區塊驗證:Prover Network(證明網路)從排序器獲取區塊和見證數據,通過專用硬體設備進行驗證,生成證明並返回給排序器。

- 狀態更新:Fullnode Network(全節點網路)從排序器接收狀態差異,更新本地狀態,同時可以通過證明網路驗證區塊的有效性,確保區塊鏈的一致性和安全性。

先測量,再執行

從白皮書其它內容看,MegaETH 自己也意識到了,這個「節點專業化」的思路不錯,但不意味著能夠非常簡單的將思路付諸於實踐。

在具體做鏈時,MegaETH 有個思路其實不錯:先測量,再執行。即先進行深入的性能測量,以確定現有區塊鏈系統的真正問題,再來看怎麽把這個節點專業化的思路放到現行系統中解決問題。

那麽,MegaETH 測出了哪些問題?

下面這部分其實都離韭菜們比較遠,沒有耐心的話可以直接翻到下一章節。

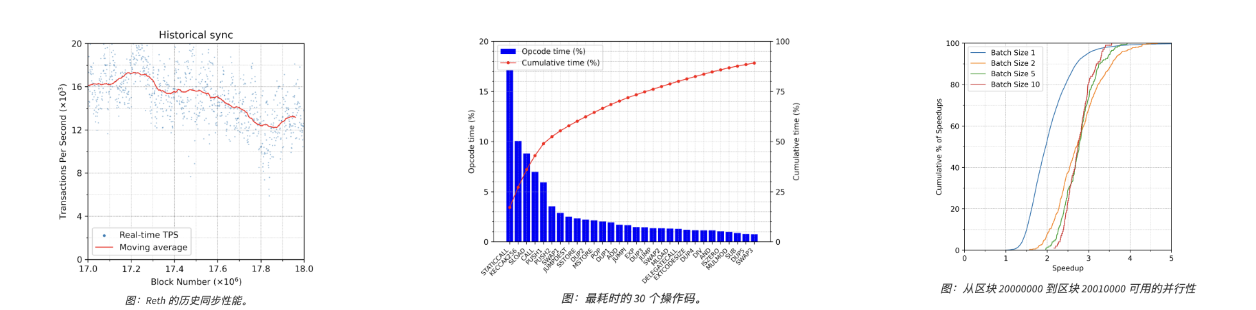

交易執行:他們的實驗顯示,即使使用配備 512GB 內存的強大伺服器,現有的以太坊執行客戶端 Reth 在即時同步設置中也隻能達到約 1,000 TPS(每秒交易數),這表明現有系統在執行交易和更新存在顯著的性能瓶頸。

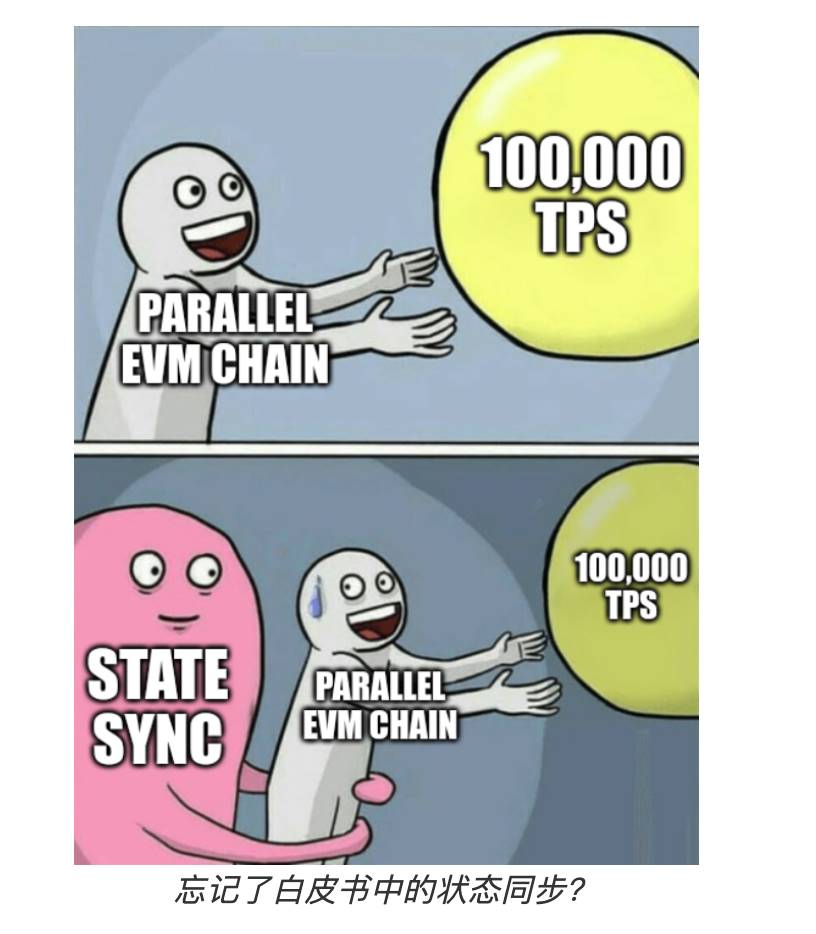

並行執行:來到大熱的並行 EVM 概念,其實也有一些性能問題沒解決。並行 EVM 實際生產中的加速效果受到工作負載並行度的限制。MegaETH 的測量顯示,最近的以太坊區塊中,中位數並行度小於 2,即使將多個區塊合併,中位數並行度也僅增加到 2.75。

(並行度小於 2 表示在大多數情況下,每個區塊中只有不到兩個交易可以同時執行。這表明目前區塊鏈系統中的交易大多是相互依賴的,無法進行大規模的並行處理。)

- 解釋器開銷:即使是較快的 EVM 解釋器,如 revm,其速度仍比本地執行慢 1-2 個數量級。

- 狀態同步:同步每秒 10 萬次 ERC-20 轉帳,需要消耗 152.6 Mbps 的帶寬,而更複雜的交易則需要更多的帶寬。更新狀態根在 Reth 中比執行交易要耗費多 10 倍的計算資源。說人話就是現在的區塊鏈資源消耗有點大。

測完這些問題後,MegaETH 才開始對症下藥,也就更能理順上文所說的解決方案邏輯:

1、高性能排序器:

- 節點專門化:MegaETH 通過將任務分配給專門的節點來提高效率。排序器節點專門處理交易排序和執行,全節點負責狀態更新和驗證,證明節點使用專用硬體設備驗證區塊。

- 高端硬體設備:排序器使用高性能伺服器(如 100 核心,1TB 內存,10Gbps 網路)來處理大量交易和快速生成區塊。

2、狀態訪問優化:

- 內存儲存:排序器節點配備大量 RAM,能夠將整個區塊鏈狀態儲存在內存中,從而消除 SSD 讀取延遲,加快狀態訪問速度。

- 並行執行:儘管並行 EVM 在現有工作負載中的加速效果有限,MegaETH 通過優化並行執行引擎,並支持交易優先級管理,確保關鍵交易在高峰時期也能及時處理。

3、解釋器優化:

- AOT/JIT 編譯:MegaETH 通過引入 AOT/JIT 編譯技術,加速計算密集型合約的執行,即使在生產環境中大多數合約的性能提升有限,但對於特定的高計算需求場景,這些技術仍能顯著提升性能。

4、狀態同步優化:

- 高效數據傳輸:MegaETH 設計了一種高效的狀態差異編碼和傳輸方法,能夠在帶寬有限的情況下同步大量狀態更新。

- 壓縮技術:通過採用高級壓縮技術,MegaETH 能夠在帶寬限制內同步複雜交易(如 Uniswap 交換)的狀態更新。

5、狀態根更新優化:

- 優化的 MPT 設計:MegaETH 採用優化的 Merkle Patricia Trie(如 NOMT),減少讀寫操作,提高狀態根更新的效率。

- 批處理技術:通過批量處理狀態更新,MegaETH 能夠減少隨機磁盤 IO 操作,提高整體性能。

上面的東西其實都很技術,但是跳出這些技術細節,實際上你可以看到 MegaETH 是真正在技術上有幾把刷子的,也能明顯感覺到一個動機:

通過公開詳細的技術數據和測試結果,試圖增強項目的透明度和可信度,讓技術社群和潛在使用者對其系統的性能有更深刻的理解和信任。

名校團隊,屢受青睞?

在解讀白皮書的過程中,可以明顯感覺到雖然 MegaETH 在名字上有點浮誇,但文檔和說明又時常透露出一種技術 Nerd 的嚴謹和過於細節化。

公開資料顯示,MegaETH 的團隊似乎有華人背景,且執行長 Li Yilong 來自斯坦福,是計算機科學方向的博士;而技術長 Yang Lei 則是麻省理工的博士,商務長 Kong Shuyao 則是哈佛商學院的 MBA 出身,有多個圈內機構的工作經驗(ConsenSys 等);成長負責人則與商務長某些履曆重疊,且也來自於名校紐約大學。

一個團隊,4 個人全部來自美國頂級名校,人脈和資源上的影響力不言而喻。

之前,我們也在《畢業生當 CEO,Pantera 領投 2,500 萬的 Nexus 是何來頭》一文中介紹到,Nexus 的執行長雖然是應屆畢業生,但同樣出名校自斯坦福,且看上去也有紮實的技術背景。

頂級 VC 果然更偏愛頂校技術大佬們,再加上 Vitalik 也參投和名字上帶了「ETH」,技術敘事和行銷效果可能都會拉滿。

在目前老「天王」變「天亡」,項目青黃不接、行情不上不下的現在,MegaETH 顯然還會帶來新一輪 FOMO 效應。

更多關於項目測試網和互動的資訊,我們也會持續保持關注。

【免責聲明】市場有風險,投資需謹慎。本文不構成投資建議,使用者應考慮本文的任何意見、觀點或結論是否符合其特定狀況。據此投資,責任自負。

- 本文經授權轉載自:《深潮 TechFlow》

你可能想知道